1Uサーバーに20枚のGPU搭載? LIQID CDI:『GPUオンデマンド』のご案内『後編』

本内容は、2024年6月に弊社メールマガジンにて配信したものを一部改版し、掲載しています。前編は、こちら

LIQID社のComposable disaggregated infrastructure(コンポーザブル・ディスアグリゲーティッド・インフラストラクチャ)略して、CDI製品のご案内の「後編」となります。「前編では」、『CDIの提供価値』として次の項目を挙げさせて頂きました:

- GPU等PCIeデバイスのプール化によるHW資源のオンデマンド利用

- サーバーの機構的制約を取り払いGPU搭載密度の常識を破る

- TCOの削減(初期投資、運用コスト)

上記#1. では、例を挙げてGPUなどPCIeデバイスをオンデマンドで活用できる点を説明させて頂き、また、LIQIDでは、このCDIの概念をGPUカードに特化したソリューションとして、より分かり易く示したものを『GPUオンデマンド』と呼んでいる旨をご紹介致しました。

さて、「後編」では「#2. サーバーの機構的制約を取り払いGPU搭載密度の常識を破る」より説明を続けさせていただきます。

先般のGPUサーバー製品を見ると、1サーバーに搭載可能なGPUカードの数が最大で8枚程度のモデルが多いようです。前編でご紹介したLIQID CDI/GPUオンデマンドソリューションを採用いただくと、1台のサーバーに最大で30枚(*1)のGPUカードを接続することが可能です(*1 Dell R760など一部のサーバーモデルによる、詳細はお問い合わせください)。

これは、LIQID社の拡張ボックス内にGPUカードをまとめてプールし、PCIeファブリックスイッチを介してサーバーと接続することで可能になります。1台の拡張ボックスには最大で10枚のダブルスロットGPUを搭載でき、この拡張ボックスを追加いただくことでGPU数を増やすことが可能です。これにより、CPUよりもGPUワークロード処理を要するシステムにとっては、大きなアドバンテージを得ることが出来るようになります。

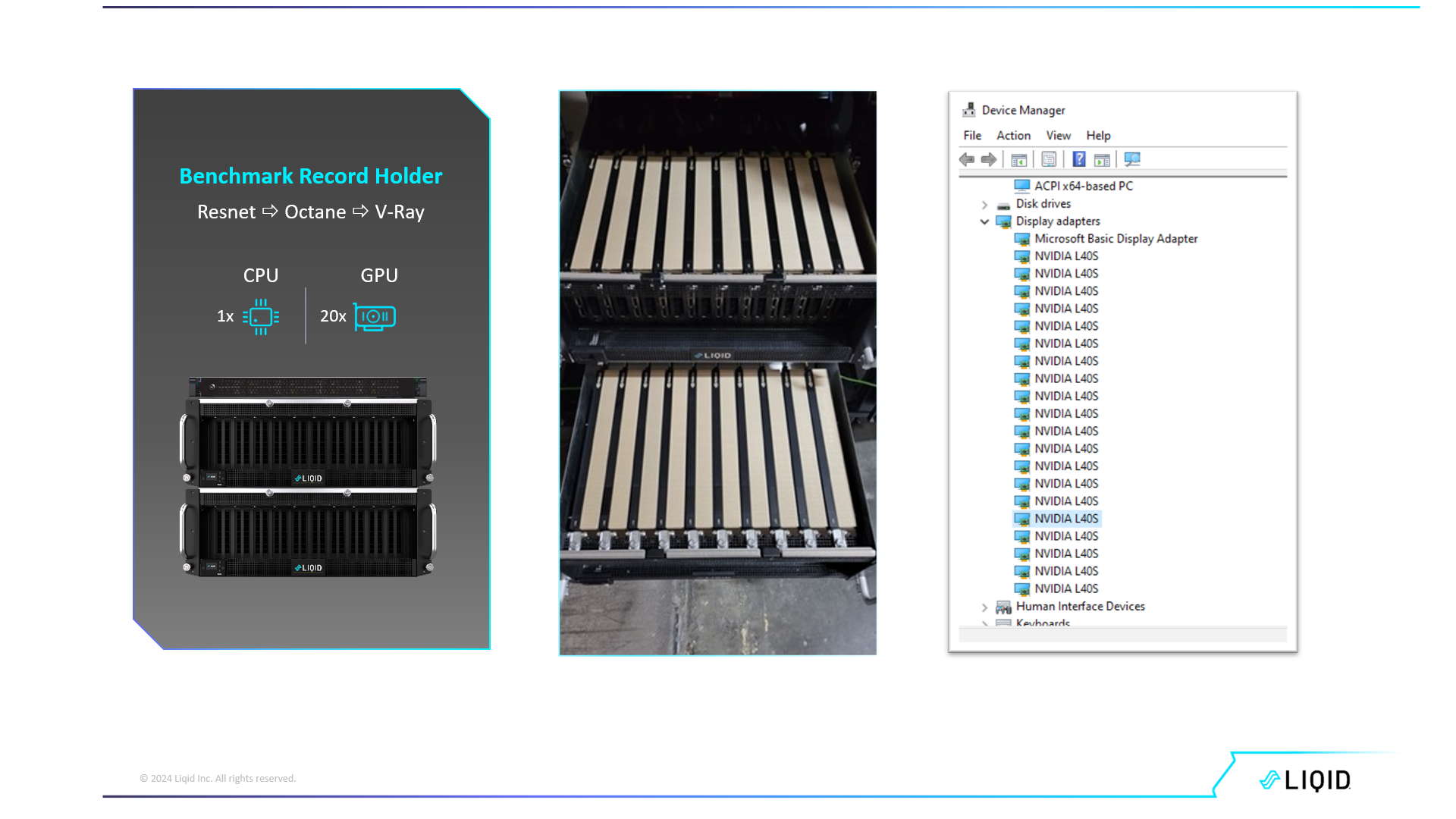

サーバーには、PCIeスイッチチップを搭載したHBAのみ搭載するだけで、冒頭挙げたようにレガシーなサーバー製品では搭載できない数のGPUを接続することが可能です。一例ですが、以下のように1Uサーバーに20枚のGPUカードを接続することも可能です。

上図は1台のサーバー構成ですが、拡張ボックスにGPUを導入しプール化しておくことで、複数のサーバーで動的に同様の構成を組むことが可能です。

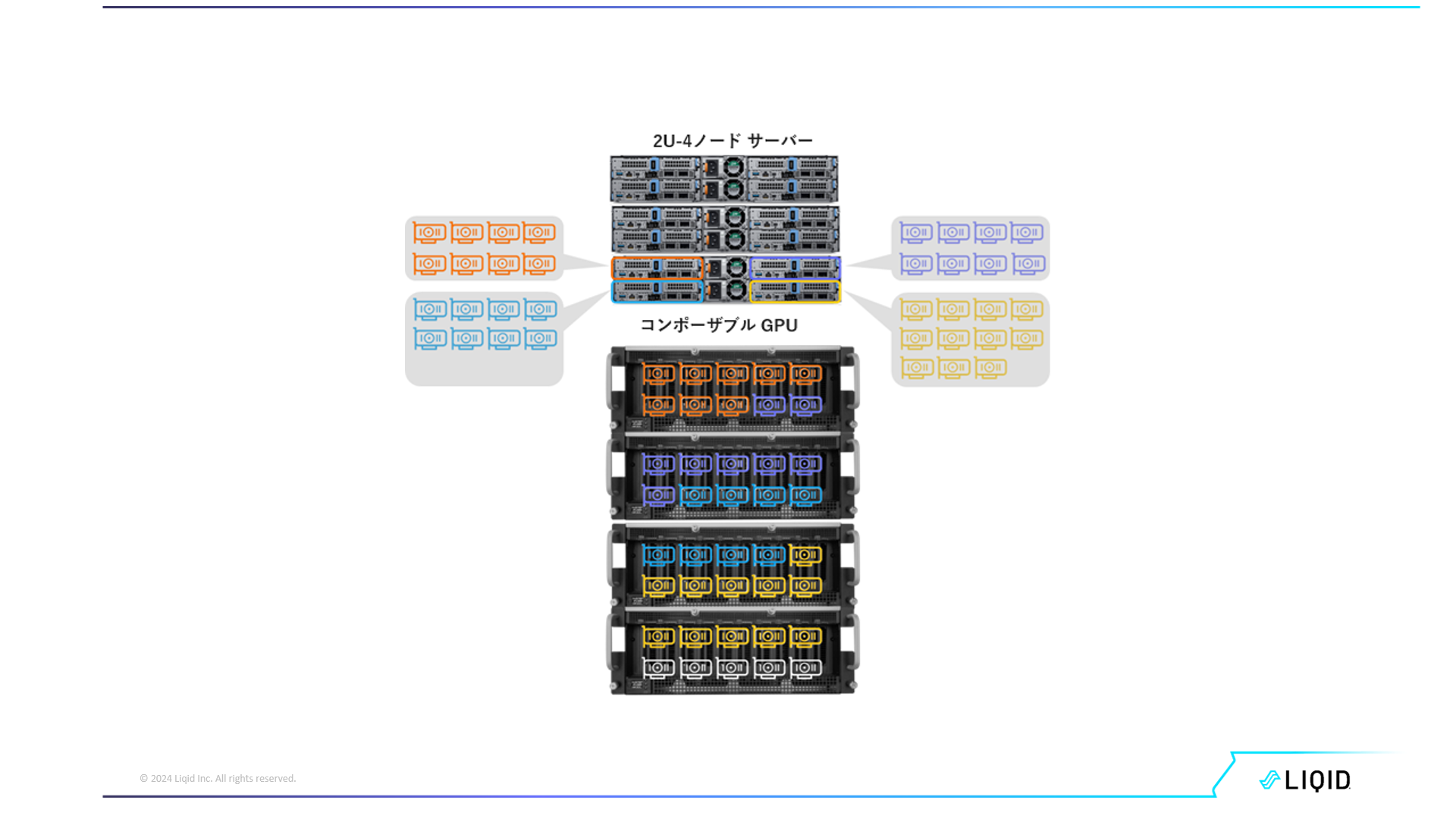

更に言えば、筐体構造上スペースあるいは排熱性能の不足でGPUカードを許容できないブレードサーバーなどにGPUを搭載する拡張ボックスを接続することで、例えば2U 4ノードのサーバーでもGPUサーバーとして活用することが可能となります。

LIQIDの「GPUオンデマンド」による既存システムに対する投資の保護の一例です。

以上が提供価値 #2に挙げた「サーバーの機構的制約を取り払いGPU搭載密度の常識を破る」ということになります。

さて、最後に提供価値「#3.TCOの削減(初期投資、運用コスト)」についてご紹介いたします。

1台のサーバー当たりのGPU密度を上げサーバー台数を削減することができれば、言うまでもなくサーバー調達のコストを削減することができます。加えて、台数が減ることで、OSならびにアプリケーションソフトウェアのライセンス費用の削減が可能になります。またCDIトポロジーでは、サーバー同士をIBやEthernetなどのネットワーク接続ではなくPCIeスイッチを介したネイティブなバス接続になるため、通信オーバーヘッドの削減によるレイテンシ、スループットの向上が期待できます。これにはLIQID独自のGPU間通信オフロード技術の貢献もあり、ネットワーク接続と比べて35%性能改善し、ネットワーク設備への投資を削減することと合わせて大きなメリットになります。

現在GPUカードは、生成AIのみならず動画編集やレンダリング、ハイパフォーマンスコンピューティング(HPC)、画像認識、機械学習、推論、など様々な用途に使用されており、それら用途に応じて様々なGPUサーバー要件があります。そのため、一旦、特定の用途に最適なGPUサーバーを構成しても、それを他の用途に転用することが難しかったり、そのため折角投資したGPUサーバーの使用率を上げる事が難しくなったりします。

これが、結果的に使用率の低いGPUサーバーを生んでしまう一因になっているのではないかと推測します。

少し細かく見ると、1台のGPUサーバーを構築するには、サーバー本体や高価なGPUカード等などの初期調達コスト、更にOSやアプリケーションのライセンス費用、保守サービス、そして、設置スペースコスト(ラック)、電力など、稼働し続けるための運用コストが必要となります。そしてそれほどの費用をかけて構築・運用しているサーバーであっても、使用率が低ければTCO(総所有費用) としてはとても残念な評価になってしまいます。

ご紹介してきたように、LIQID CDIはそのような結末を未然に防ぐことができる先進のソリューションです。CDIソリューションを活用する事で、用途に応じてGPUなどのPCIeデバイスを組み合わせ動的にベアメタルサーバーを構成し、使用後はPCIeデバイスをプールに戻し、サーバーを解放し再利用に供する、そのようにして、使用率の低いサーバーを生むことを未然に防ぐことが出来ないでしょうか。

以上のようにLIQID CDIソリューションは、高価なハードウェア資源であるGPUをサーバー間で効率よく共用し、また既存のサーバー製品では実現できないGPU搭載密度を可能にするだけでなく、システム構築コストと消費電力などの導入から運用に至るTCOの削減に貢献し、またシステム導入時には予見しえない将来のシステムニーズの変動にも備えることで投資を保護することも可能です。

なお、最後になりましたがLIQID CDIでは、NVIDIA、Intel、AMD、Xilinx、Qualcommといったマルチベンダーでの異機種モデルの混合での搭載・動作も可能となっており、またNVIDIAの認定システムであるNVQualやNVCertでの登録もございます。

前編、後編と最後までお読みいただき、誠にありがとうございました。

LIQID CDI / GPUオンデマンド ソリューションにご関心いただけましたら、弊社営業担当あるいは、sales-contact@servants.co.jp 迄ご連絡をお願い致します。弊社では、LIQID社のCDIデモシステムがございますので、実際に動作デモをお見せすることもできますのでご遠慮なくお問い合わせください。

LIQID社ホームページ : https://www.liqid.com/

Servants LIQID CDIページ :

https://www.servants.co.jp/product/solution/composable/8828/

サーヴァンツインターナショナル株式会社