GPUカードをより効率的に活用する、LIQID CDI:『GPUオンデマンド』『前編』

本内容は、2024年6月に弊社メールマガジンにて配信したものを一部改版し、掲載しています。

LIQID社のComposable disaggregated infrastructure(コンポーザブル・ディスアグリゲーティッド・インフラストラクチャ)略して、CDI製品のご案内となります。

CDI?フルセンテンスを発音しようとすると舌を噛みそうになり、またそれを聞いても、「正直ピンとこないなぁ」と思われる方が多数かもしれません。 はい、その気持ち、とてもよく分かります 笑)。

「Composable Disaggregated Infrastructure」を簡単に説明すると、個別のサーバー内部のPCIeデバイス(GPU, NIC, SSDなど)を複数のホストサーバー間で動的に共有・解放できるようにする技術です。構成する英単語の和訳例は以下のようです。

- Composable : 複数のエレメントを含み合わせて、新たな構成を作り出すことが可能な

- Disaggregated : 集合体を個々のエレメントに分解・解放した状態

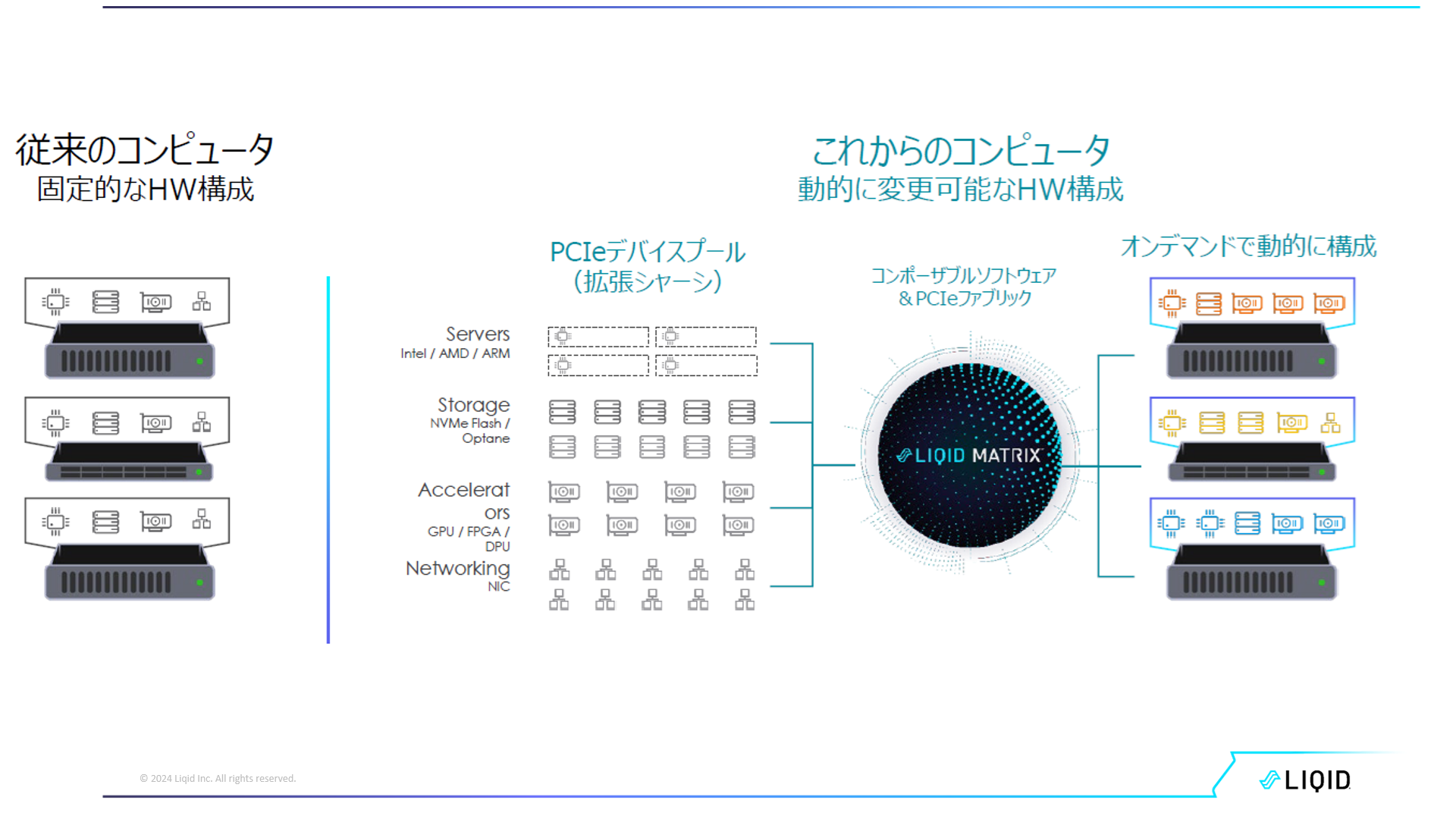

データセンターでのサーバーの利用形態のトレンドは、過去、プライマリ、セカンダリ、アーカイブといった階層構造のストレージを手動にて運用する固定的なHW構成の時代から、スピードや柔軟性の面より、ストレージとサーバーを事前に構成して運用するハイパー・コンバージドの世代を経て、更に効率的な運用を目指した結果、今回ご紹介するサーバー構成を動的にPCIeデバイス単位に構成・解放することが出来る「CDI」ソリューションという流れとなっています。

端的に言い換えると、「CDIとは用途に応じてベアメタルサーバーを動的に構成する」となりますが、これはサーバーの基本エレメントである「CPU+メモリー」に「必要な種類のPCIeデバイス」を「必要な数」だけ追加して動的にサーバーを構成することを意味します(次PCIe世代ではこの基本エレメントも動的に構成できることが期待されています)。

実際の運用では、適切に導入が完了しているCDIハードウェアシステムをLIQID社のCDIソフトウェアのGUIで設定操作する、つまり「必要な種類のPCIeデバイス」を「必要な数」だけPCIeデバイスプールから選択し、OSやアプリケーションが搭載された稼働状態のサーバーに割り当てるだけで、約20秒ほどでベアメタルサーバーが構築(compose)され、即時に使用開始することができます。また、サーバーの使用後は、割り当てていたPCIeデバイスをすべて解放(disaggregated)し、PCIeデバイスプールに戻すことで即時に再利用が可能です。

言うまでもなく、CDIは複数台のサーバーでPCIeリソースプールを共有することを当然としていますので、同時に複数台のベアメタルサーバーを構築することが出来ます。

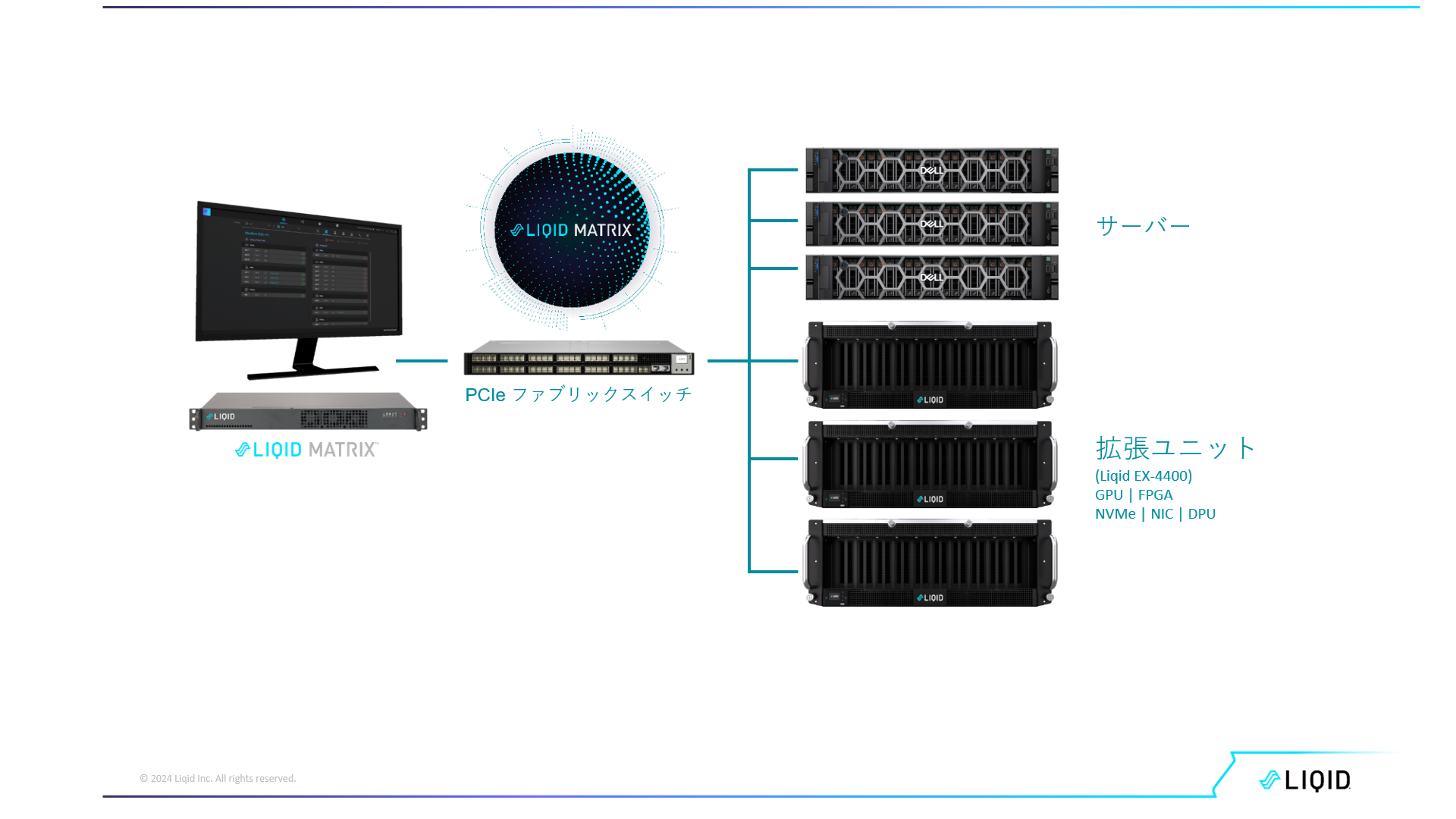

この場合、各サーバーにはPCIeスイッチチップを載せたホスト・バス・アダプタ― (以下、HBA) を搭載し、このHBAを介してLIQID CDIシステムの構成要素であるPCIeファブリックスイッチに接続されます。LIQID CDIシステムの基本トポロジーは下図のとおり、サーバー群、各種PCIeデバイスが搭載されている拡張ユニット、管理用ソフトウェアが動作する1Uサーバー、そしてそれらすべてが接続されるPCIeファブリックスイッチとなります。

既に北米では、Meta、SONY、Orange、VISA、GM、テキサス大付属MDアンダーソン癌センター、DoD、FBI…等々300弱の採用実績があります。

そして、この LIQID CDIソリューションの核となっているのは、「PCIeスイッチ機能」と各サーバー間で動的にPCIeデバイスを共用可能にする「CDI管理ソフトウェア Matrix」です。

LIQID CDIソリューションは、例えばGPUカードを分割して複数のGPUカードとして活用するvGPUなどの仮想化ソリューションとは異なり、割り当てられたPCIeデバイスはサーバーに搭載されている実PCIeデバイスとして構成されるリアルなソリューションです。LIQIDは、既にGPU、NVMe SSD、FPGA、NIC/DPUなど、動作検証済みのPCIeデバイスが多数HCLに掲載しており、更にHCLの充実に取り組んでいます。

さて、この特徴的な仕組みの結果、『CDIの提供価値』として次の項目が挙げられます。

- GPU等PCIeデバイスのプール化によるHW資源のオンデマンド利用

- サーバーの機構的制約を取り払いGPU搭載密度の常識を破る

- TCOの削減(初期投資、運用コスト)

#1のHW資源のオンデマンド利用は、昨今のGPUカードの入手難下では一つの有効な解決策となり得ます。所有しているGPUを必要なワークロードに割り当て、使用後は他ワークロードのために解放するCDIを採用することで、GPUカードの共用化、システム全体としてのGPU使用率を大幅に改善することが可能です。

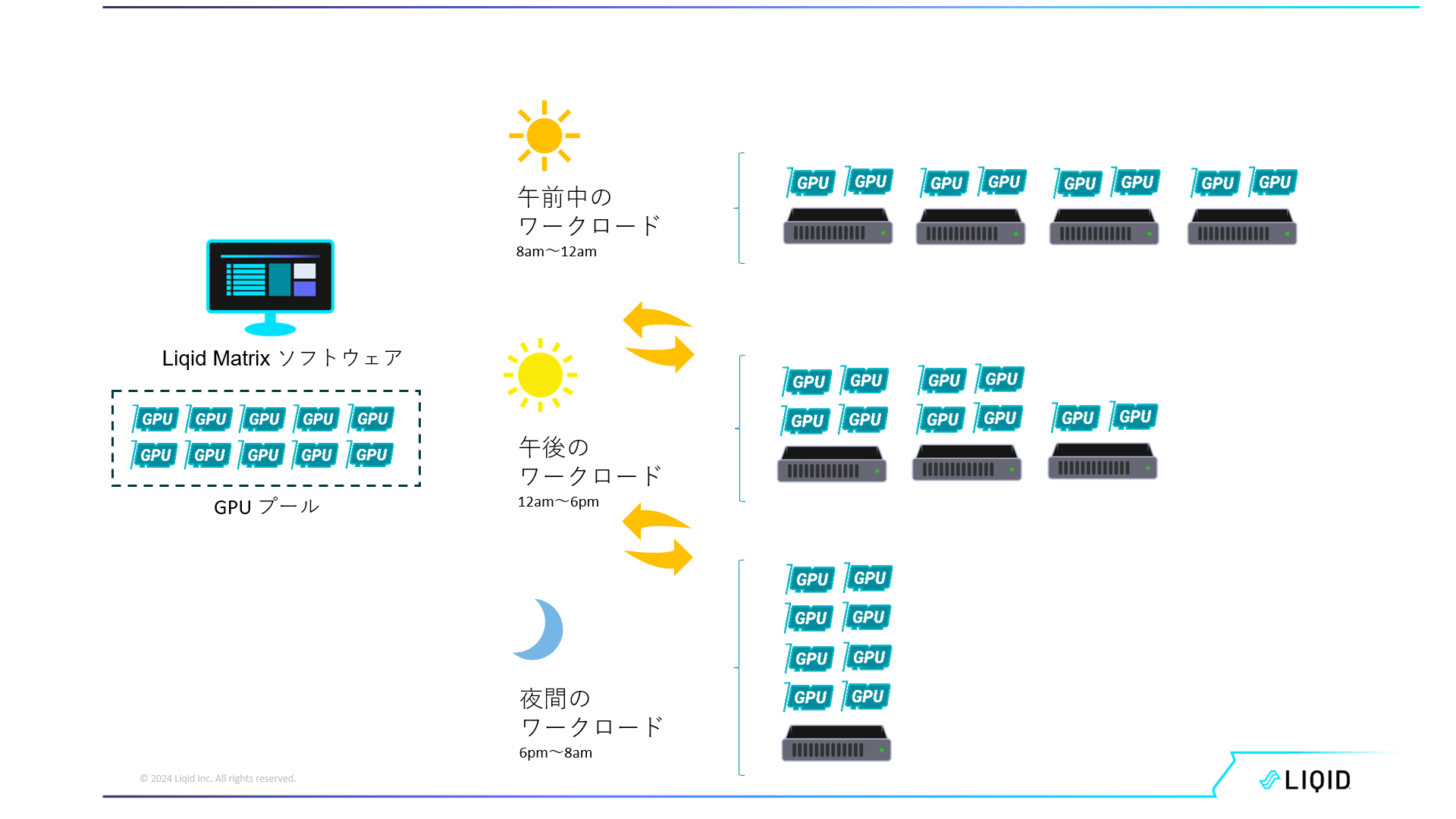

CDIによりGPUカード/他PCIeデバイスをプール化することで複数のサーバー間での共用が可能になり、時々刻々変化するワークロードの最適な処理が期待できます。

一例ですが、10枚のGPUカードをプールしたCDI構成で、午前中はGPUカード2枚のGPUサーバー4台を構築しそれぞれのワークロードを処理し、午後にはGPUカード4枚を搭載するサーバー2台とGPUカード2枚を搭載したサーバー1台、夜にはGPUカード8枚を搭載したサーバー1台を構成といった使用が可能になります。

(実際にこれを物理的なGPUカードの差し替えで実現しようとすると、半年もたたずにサーバー側のPCIeスロットの「着脱保証限界」を超えることになります。)CDIソリューションではこのような物理的な着脱を回避し、サーバーの構築・解放がGUI操作のみで約20秒ほどで完了するため、ハードウェアやエンジニアに負担をかけることなく構成・解放を繰り返すことが可能です。

LIQID社では、このCDIのベネフィットをGPUカードユーザーにより分かり易くお伝えするために『GPUオンデマンド』と呼んでいます。

長くなりましたが、最後までお読みいただき有難うございました。

「後編」では、上述の「提供価値2.サーバーの機構的制約を取り払いGPU搭載密度の常識を破る」と「提供価値3. TCOの削減(初期投資、運用コスト)」についてご紹介したいと思います。

LIQID CDI / GPUオンデマンド ソリューションにご関心いただけましたら、弊社営業担当あるいは、sales-contact@servants.co.jp 迄ご連絡をお願い致します。弊社では、LIQID社のCDIデモシステムがございますので、実際に動作デモをお見せすることもできますのでご遠慮なくお問い合わせください。

LIQID社ホームページ : https://www.liqid.com/

Servants LIQID CDIページ :

https://www.servants.co.jp/product/solution/composable/8828/

サーヴァンツインターナショナル株式会社